TzTech005 - 随笔

随笔,梳理一下最近一个月的见闻。

随笔,梳理一下最近的见闻。

Ilya 播客

1

2

3

Ilya Sutskever – We're moving from the age of scaling to the age of research

https://www.youtube.com/watch?v=aR20FWCCjAs

date: 20251125

重点:模型在 Scaling 上和 Benchmark 上展现出非常好的效果,但是缺少鲁棒性、推理、长思考、持续学习,以及可控性。Ilya 强调 Research 的重要性。

RL 中写入的 “Benchmark 向好” 行为,导致评测与真实能力脱节。预训练与人类获得数据量脱节。agent 长决策,agentic LLM。==显式 value model(步骤级可学习信号)、分层价值(hierarchical value)、以及把 value 用在搜索/规划(减少无效 rollout),同时用它做可解释诊断(哪一步开始走偏)。==需要少量学习获得更多成本,即更强的学习算法。

LLM RL

1

2

3

4

5

6

7

漫谈LLM RL post-train(1)模型没有被训练去泛化

https://mp.weixin.qq.com/s/f15HvJ5qZROOf7T_9QhD-A

date: 20251204

---

漫谈LLM RL post-train(2)Coding Agent

https://mp.weixin.qq.com/s/pni4HgERjOkmjBbT4rr3vw?scene=1

date: 20251209

作者指出最大的问题在于:“最大的问题是,LLM并没有在RL训练中被要求去学习在新环境中如何泛化/应对。”

作者从原理下手,认为 RL post train 的训练习惯 —— 用大量 sample 训练某种 task —— ==没有激励模型的跨 task 的泛化能力==。提出了 RL Post-Train Task Augmentation,具体来说就是给每轮 rollout 中添加较大的随机性,减少模型的肌肉记忆。

作者还提出仿真环境投入严重不足,拿 Vibe Coding 举例(上文 Ilya 也拿了 Vibe Coding 举例),也是讲的 RL。我认为作者最宝贵的观点是:==AI Coding问题较复杂,单纯的搜集用户当前环境和依赖库版本、项目已有代码、用户prompt等等,仍然还缺乏reward的部分。==对于作者“具体来说”的部分的第一点,用户环境,venv 这些,我认为直接在 agent 层面上是比较好解决的。第二点,用户的项目与需求这块,Vibe Coding 最大的问题就是瞎改用户的习惯,然后导致错误,这点我深表认同,结合最近很火的 TTT,我认为这里可以用 TTT 继续改进。

“Pretrain scaling 时代我们有着免费的跨领域泛化午餐,但RL post train时代并没有了,Ilya也说了这点。”

Prompt Engineering - 圣诞树

1

2

3

gemini3手势互动圣诞树保姆级教程来了!附提示词

https://zhuanlan.zhihu.com/p/1981732280851506856

date: 20251209

只能说 Prompt Engineering 还是有用的,要给懂技术栈的人用。

Skills

1

2

3

Don't Build Agents, Build Skills Instead – Barry Zhang & Mahesh Murag, Anthropic

https://www.youtube.com/watch?v=CEvIs9y1uog

date: 20251209

演讲者来自 Anthropic。Claude 相继提出 MCP 等概念,这次提出了 Skills。解决的问题如上面的用户代码风格,个人习惯与 Coding 工具不统一的问题。Anthropic 不想造那么多专用 Agent,而是想用 Skills 让通用 Agent 在不同领域能有不同能力的发挥。

架构如下:

1

2

3

4

5

anthropic_brand/

├── SKILL.md

├── docs.md

├── slide-decks.md

└── apply_template.py

skill 具有节省上下文的能力,启动时只有元数据进入 Prompt,模型需要该功能的时候才读取完整 Skill 内容。

上下文

1

2

3

Understanding and Improving Information Preservation in Prompt Compression for LLMs

https://arxiv.org/pdf/2503.19114v2

date: 20251010

记得最近有人解构了 GPT 的上下文管理机制,待会找一下来读。这篇主要讲的是提示词压缩。

论文把压缩方法的质量拆成三个维度:1)下游任务表现;2)回答对原输入的 grounding 程度;3)信息保留(information preservation)能力。

作者改造压缩粒度,实现效果提升。

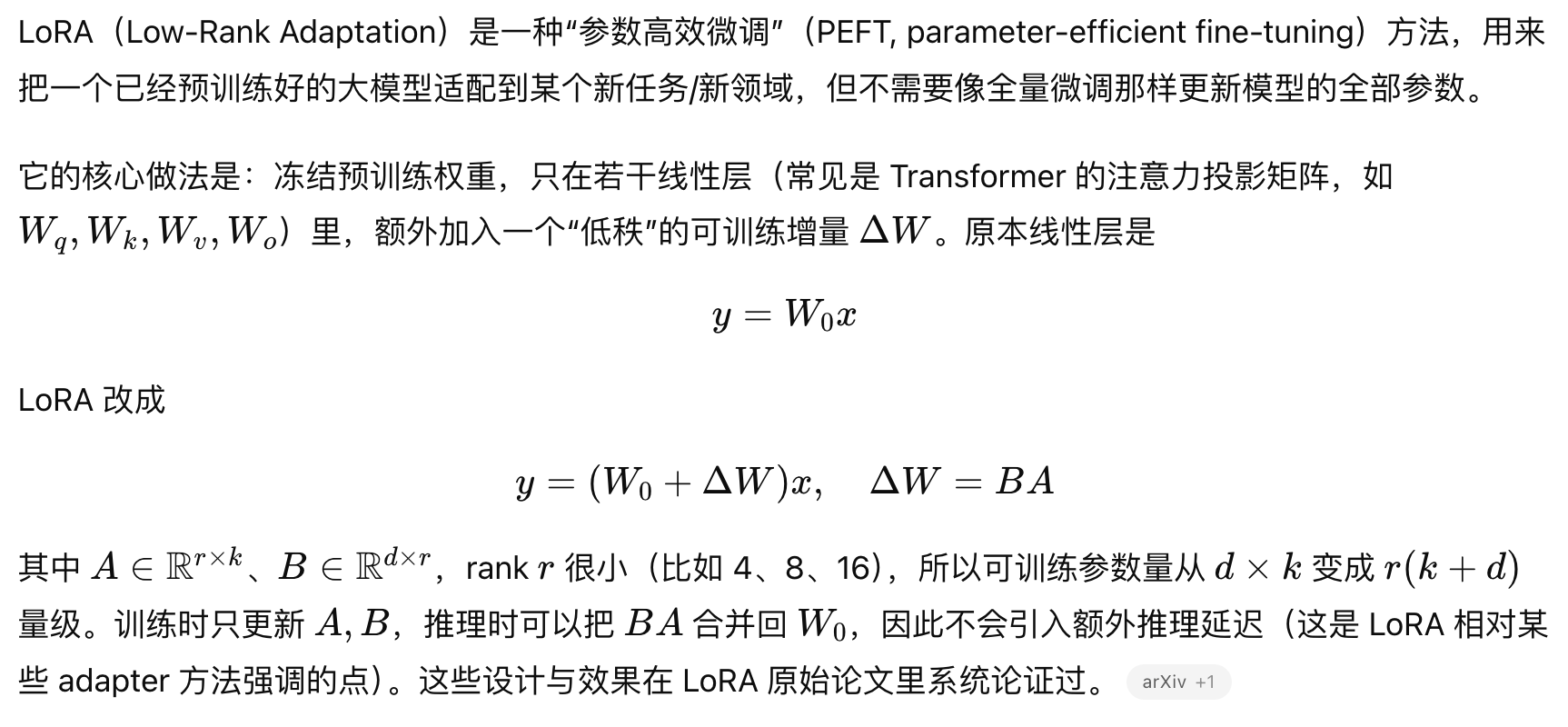

微调

1

2

3

猫娘是怎样炼成的——记录一次曲折的大模型微调经历

https://zhuanlan.zhihu.com/p/1980670280922861774

date: 20251203

一万条数据,PyTorch。LoRA。结论是数据集不够。秩,学习率。

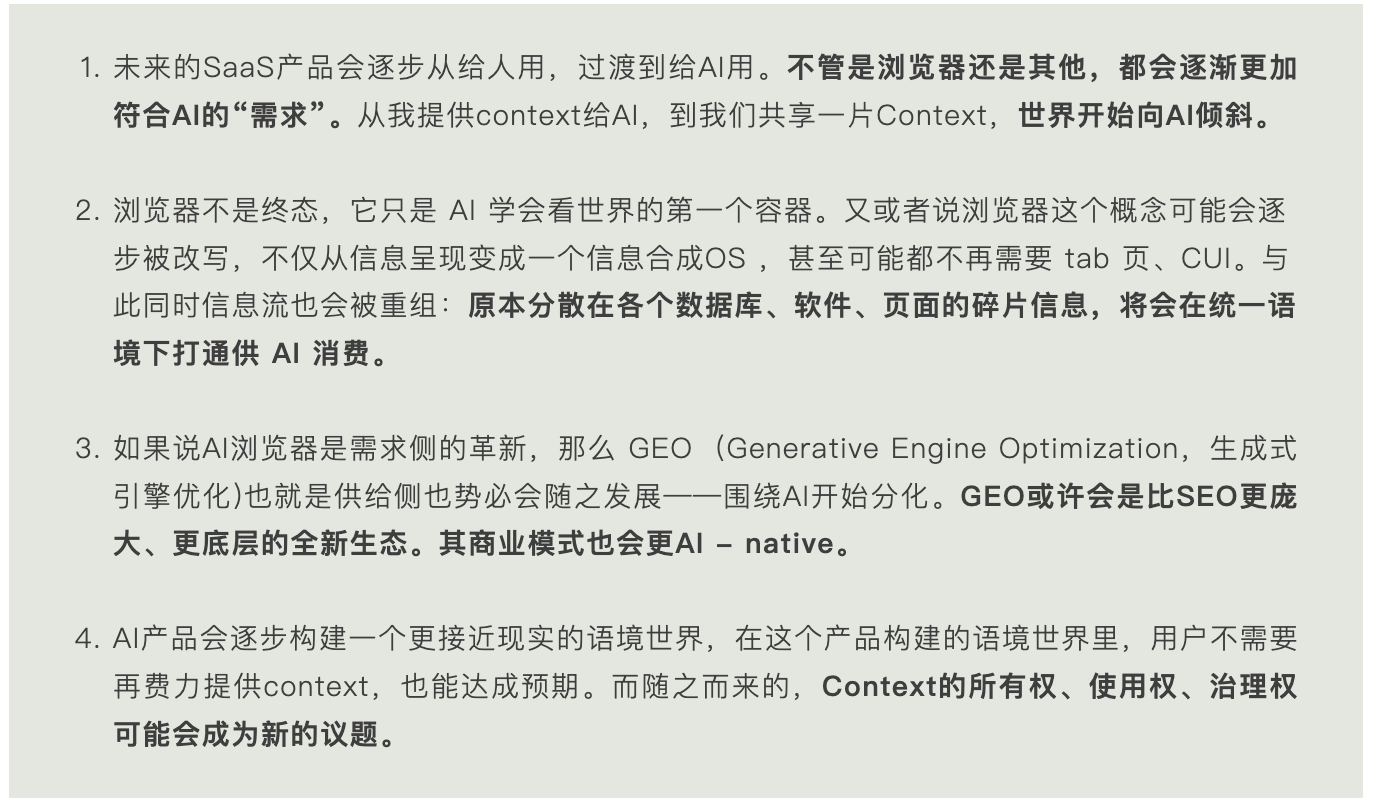

OpenAI Atlas

1

2

3

当世界开始向AI倾斜:试用Atlas一个半月的感受

https://mp.weixin.qq.com/s/Eu697Re2PzKbeGlskXkWyg

data: 20251214

先讲我==个人的观点==:Agent 额度每月只有 40,远远不够正常使用。效果比 Comet 好,逻辑实现不一样,Comet 使用类似 VLA 的流程,而 Atlas 是 DOM 操作。Atlas 无法实现光标程度的控制,而且我们知道的,图片信息更加完整、可信度更高,Atlas 做作业,有各种奇怪的填空时,效果并不好。(也许需要“页面专属 Memory + Skills”)

接下来我们看看文章==作者的观点==。“GPT 的 Agent 刚发布的时候属实很一般,我记得当时我测了几个任务都没跑完,所以那之后就一直没再用,感觉很鸡肋。”深表认同,个人认为是 GPT 远程浏览器的锅,很多网页不让他进,人机验证半天。

作者也提到了 Manthan Gupta 对 ChatGPT 记忆的逆向工程 —— 四层架构:适配环境的会话元数据、关于用户的长期事实、近期对话的轻量摘要、当前会话消息。不过我觉得是不是可以像我上面说的那样拥有“专属记忆”?

作者是产品经理,我觉得观点还是比较到位的。

作为 Opera 用户,Opera 让我难以割舍的地方是:超级快速的同步,超绝的文件管理能力。Opera 的同步,两台电脑上几乎没有延迟,并且对于历史访问比较多的链接记忆时长是比较久的。侧边栏也不错,虽然用的不多。另外一个是下载、上传功能,上传可以快捷选择刚刚下载的文件,或者是刚刚添加到下载文件夹的文件,同时支持将剪贴板的内容一键上传,这个功能是其他任何浏览器都没有的,也是我认为世界上最好用的功能!所以我觉得 Atlas 在体验上有待优化,目前的感觉是 Chrome 味很重,除了侧边栏没有 GPT 自家的东西,而且菜单逻辑也不是很强。

Agent 用户偏好

1

2

3

Rethinking Agent的用户偏好挖掘(1)论文偏好对齐场景

https://mp.weixin.qq.com/s/FZALYH-9Qt2nVLO6SNa3HQ?scene=1

data: 20251228

作者提到论文偏好的对齐。我认为可以与视频平台的推送做近似?我觉得算是标签+推送算法。 评论区说:“产品中所有用户的行为(不只是用户主动对话)都应该被利用起来,目前产品交互得到的用户偏好数据量级是明显不够的。还没有积累到足够信息,用户就跑了。。。” 有道理的。

Memory

直接贴链接了,暂时还没有时间看。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

Memory in the Age of AI Agents

https://arxiv.org/abs/2512.13564

1️⃣Memorizing Transformers (Google, 2022): 融合外部记忆(KNN查找)与内部注意力,让模型能边思考边“翻书”。

2️⃣MemoryLLM (清华, 2024): 在模型每层嵌入可读写的 "memory tokens",像给大脑装了内置“草稿纸”。

3️⃣Memory³ (记忆弧量, 2024): 首次提出记忆分层框架,模拟人脑对记忆进行分层管理,让记忆组织更有条理。

4️⃣WISE (浙大, 2024): 提出“主记忆+侧记忆”双参数体系,面向终身学习和模型编辑。

5️⃣Titans (Google, 2025): 提出一个专用的神经网络模块,自主学习何时存储、何时遗忘。

⭕应用驱动——即插即用的记忆外挂 (5个典型工作)

这一方向偏向不动模型本身,在应用层构建记忆系统。优点是落地快、易扩展,缺点是受限于底层模型的能力。

1️⃣MemGPT (2023): 将LLM视为一个操作系统,通过虚拟上下文管理技术,赋予Agent无限上下文能力。

2️⃣Mem0 (2024): 一个为生产环境设计的通用记忆层,强调平台化服务与可扩展性。

3️⃣Zep (2024): 采用时序知识图谱(Temporal Knowledge Graph)来组织长期记忆,使记忆检索和理解更深刻。

4️⃣Memobase (2025): 基于用户画像(Profile)和事件(Event)构建长期记忆,能自动从对话中抽取结构化信息。

5️⃣HippoRAG (OSU等, 2024): 灵感源于神经生物学,模拟海马体的记忆形成机制。

23 research papers from 2025

TTT-E2E

1

2

3

告别KV Cache枷锁,将长上下文压入权重,持续学习大模型有希望了?

https://mp.weixin.qq.com/s/30ysdCrari7V2Rd9SUF4Kg

date: 20260102

后面的东西再整理一下吧,偏学术,感觉基础能力不足。